Apache Airflow es una herramienta de orquestación que permite crear, programar y monitorizar flujos de trabajo mediante programación en Python.

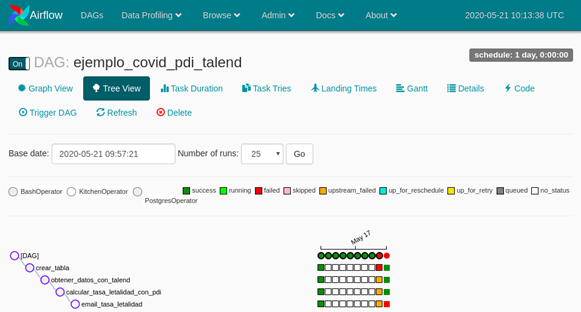

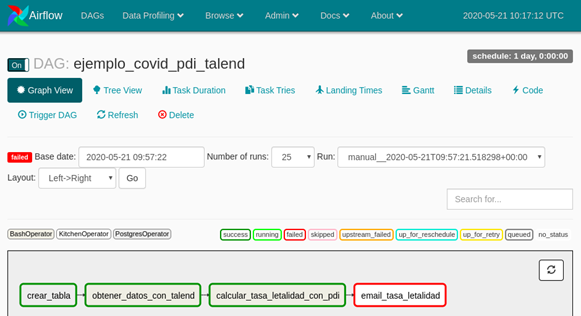

Estos flujos de trabajos se representan como Grafos Acíclicos Dirigidos o DAGs (del inglés Directed Acyclic Graph) de tareas / procesos, es decir grafos donde los datos fluyen en una sola dirección entre los procesos, por lo que si algún trabajo X falla, los trabajos que dependen del trabajo X no se ejecutan

En este enlace, puedes descargarte el paper de Introducción a Apache Airflow, explicando la configuración y con casos de uso

Permite la creación, programación y monitorización centralizada de flujos de trabajos complejos que se conectan a varios backends.

Código personalizado para la lógica de reintentos cuando una tarea falla

Orquestación estandarizada de ETLs

Permite trabajar con herramientas ETL como Pentaho Data Integration y Talend