Como ya sabréis, la archiconocida frase de que 'Los datos son el nuevo petróleo' no exenta de verdad, está haciendo que compañías y organizaciones de todo tipo (privadas, públicas, grandes, pequeñas...) quieran monetizar sus datos.

Y, de hecho, muchas de ellas lo están haciendo desde hace bastante tiempo. Algunas de forma discreta, como las grandes plataformas tipo Facebook y otras con gran profusión de promoción, como el caso de las empresas Telco y de Banca

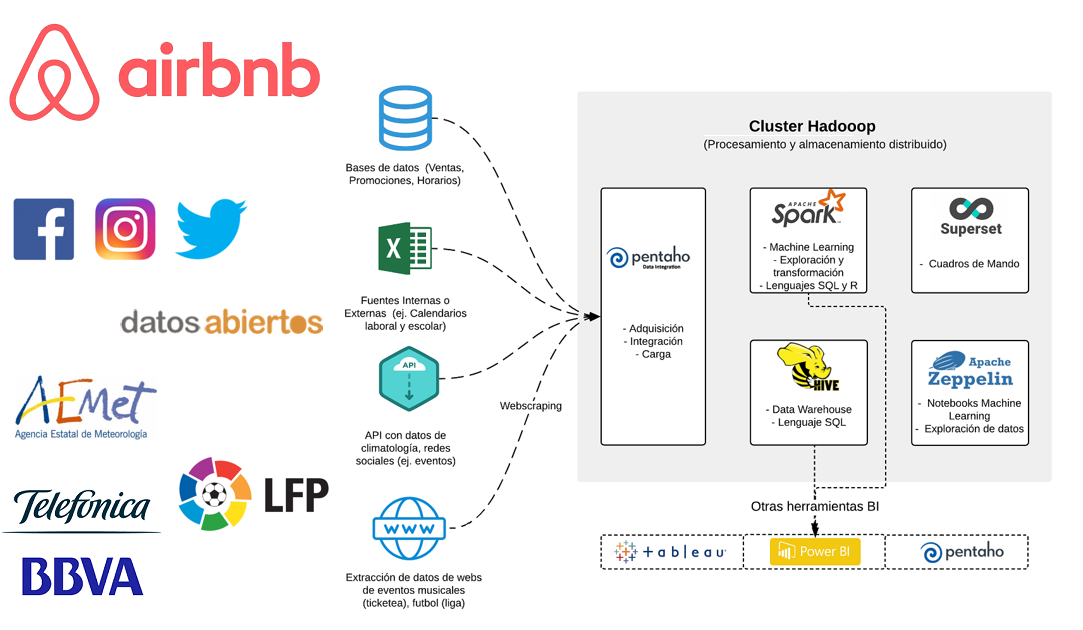

Más abajo os indico 10 Consejos que os pueden ser de ayuda a la hora de monetizar los datos de tu empresa. Para otro post, dejo el contaros como a nivel técnico se montan estas arquitecturas (aunque os dejo algunas pinceladas y un diagrama de arquitectura a modo de ejemplo), no solo para los que ofrecen/monetizan datos, sino para los que usan/compran esos datos para ingestarlos y usarlos en sus propias organizaciones

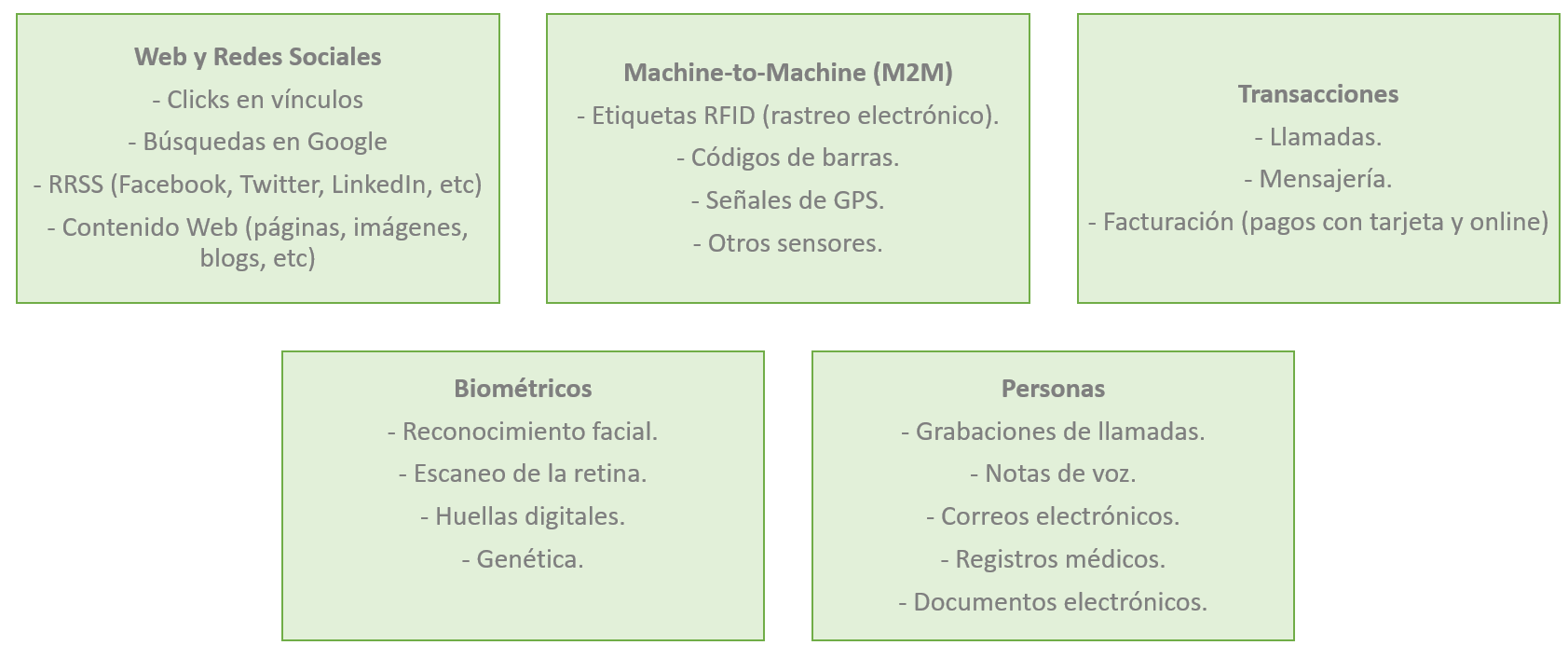

Las fuentes de datos cada vez son más sofisticadas, lo que complica sobremanera la automatización de soluciones tecnológicas para la extracción y transformación de dichos datos.

Entre los principales obstáculos están los siguientes:

- La proliferación de fuentes debido, sobre todo, a la incorporación de Internet of Things. Cada vez va habiendo más aplicativos conectados a la red, lo que requiere desarrollos específicos para extraer y analizar esos datos.

- Las páginas web requieren un análisis aparte, siendo el Web Scraping uno de los campos más candentes y productivo en cuanto a estudios e investigación.

Los principales aspectos en los que se está trabajando actualmente son:

- Las páginas se van sofisticando cada vez más para dar un aspecto más visual para el usuario y para que la navegabilidad sea más suave y atractiva. Los avances en este sentido son directamente proporcionales a la complicación a la hora de realizar web Scraping.

- Los datos no se presentan exclusivamente de manera tabulada y estructurada, sino que en muchas ocasiones se presentan de forma desestructurada (imágenes, texto, audio). Este tipo de datos necesita de desarrollos ad hoc complejos. De hecho, uno de los campos de investigación más relevantes en los últimos años es la eliminación de “ruidos”, entendidos como datos innecesarios en las páginas web (banners, imágenes, texto no relevante, etc).

- Asimismo, es inherente a internet la actualización de los datos. Para que la extracción de datos sea eficiente, es necesario diseñar algoritmos que permitan la visita periódica a las páginas web objeto de análisis, desechando datos duplicados u obsoletos.

- Los desarrolladores de webs también ponen trabas en el diseño de sus sitios para detectar visitantes automatizados, lo cual supone un obstáculo añadido para la extracción automática de datos. Algunos ejemplos de obstáculos son la necesidad de autenticación de usuario, blacklisting, honeypot traps, captchas o redireccionamientos.

La fiabilidad de los datos también necesita que se desarrollen modelos específicos para su verificación. Este apartado requiere en múltiples ocasiones de la intervención manual ante la dificultad para su automatización.

La extracción de datos de la Deep Web requiere atención especial para los desarrolladores dado que requiere de un desarrollo de algoritmos específicos que produzcan queries eficaces. No existen actualmente soluciones automatizadas para este proceso, que es otro de los campos de investigación más relevantes.

El desarrollo de la capacidad predictiva es otra de los campos de actuación más interesantes para los investigadores actualmente. La aplicación de técnicas de Machine Learning y Deep Learning para la generación de algoritmos tiene unas posibilidades de crecimiento espectaculares:

- Ejemplos de sectores donde los modelos predictivos están generando avances importantes son la sanidad, la prevención de la delincuencia o los servicios financieros.

- Uno de los subcampos más potentes es el desarrollo de redes neuronales recurrentes en el ámbito de la computación.

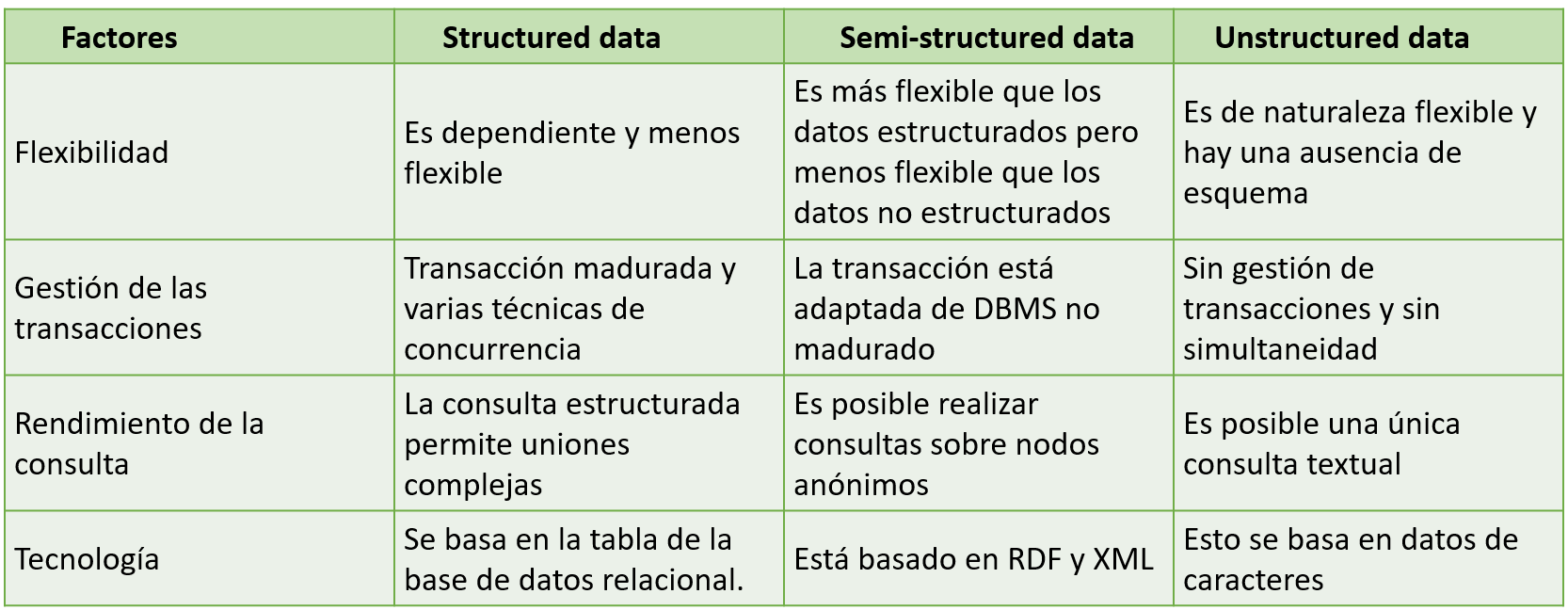

Otro aspecto relevante es conocer el formato de los datos que se quieren monetizar para su ingesta:

Estos serían mis 10 Consejos para monetizar los datos de tu empresa

1) Piensa en monetizar los datos no tanto como una forma de obtener ingresos directos por la venta de esos datos, sino como una forma de poder vender mucho mejor tus productos y servicios actuales, al generar nuevos potenciales clientes

2) Hazlo!! aunque pienses que tus datos tienen poco valor o que costará generar ingresos, pues obtienes otro beneficio previo que es el hacer un buen 'inventario' de los datos que dispones, catalogarlos, evaluar su calidad, utilidad y potencial para sinergias, lanzamiento de nuevos productos, etc...

3) Si estás pensando en un cambio de modelo de negocio en tu empresa, la opción de monetizar tus datos puede ser la mejor forma de 'modernizarla' y abrir nuevas posibilidades, líneas y modelos de negocio

4) Al querer monetizar tus datos, el primer efecto que vas a observar es que vas a entrar en contacto con muchas empresas con las que antes no tenías relación, de todo tipo. Ojo, es muy importante saber 'separar el grano de la paja', identificando aquellas empresas con las que realmente puede haber sinergias y obviando a las que te puedan hacer perder el tiempo

5) Busca otras empresas complementarias que también quieran monetizar sus datos y que sean complementarios a los tuyos. Así, la oferta a realizar a los posibles compradores de esos datos será mucho más potente y la capacidad de negociación y de fijación de precios, mucho más potente

6) Dale valor añadido a tus datos... pero no te excedas!! Me explico, si tienes datos de un sector concreto. Ej) Datos sanitarios, puedes añadir valor a los datos que quieres monetizar creando nuevos KPIs, ratios e indicadores avanzados que tu conoces por la propia dedicación al negocio. Pero no caigas en el error de querer cobrar más por esos datos 'mejorados', pues muchas empresas compradoras (generalmente grandes), están más interesados en los datos en bruto (raw) y ellos añadir la lógica o mejora de negocio

7) Es muy importante crear un sistema de extracción, transformación y preparación de los datos lo más automático posible para exponerlos y dejarlos disponibles de una forma sencilla, automática y periódica a tus potenciales clientes (tanto si es en formato de ficheros planos, base de datos, etc...)

8) Analiza muy bien la calidad, historicidad y nivel de detalle de tus datos. Si no están completos, con una buena serie histórica y nivel de detalle será muy difícil que puedas venderlos y le interesen a alguien. Por ejemplo, a nivel de banca solo los grandes bancos que cubren todo el territorio u otros muy potentes en áreas concretas podrán sacarle partido. Si tienes un negocio con datos muy repartidos, incompletos o esporádicos no serán de utilidad

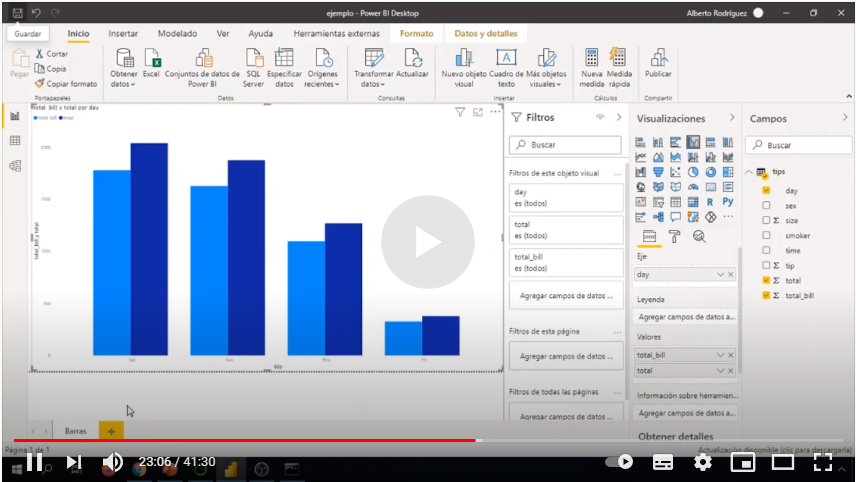

9) Intenta proporcionar también un entorno analítico (con informes, dashboards, alertas, etc...) con acceso web y sencillo a tus clientes de los datos que quieras monetizar, pero sin descuidar también el ofrecer los datos 'en bruto'. Hay muchas aplicaciones y portales business intelligence, muchos de ellos open source, que te permitirán hacerlo sin tener que invertir en costes de licencias

10) 'Convierte tus datos en un activo de negocio'. Esto ya lo comentaba en mis clases hace unos veinte años. En aquel momento era algo poco habitual. Había países como Noruega que habían calculado el valor de sus bosques, pero no era habitual saber la valoración de una empresa por el valor de sus datos. Ahora, es justo eso. Que pueden valer empresas como Facebook, Wallapop, Google y otras muchas?

Te puede interesar: