1. Introducción

Acho.io es una herramienta web que permite integrar, transformar y publicar

datos desde diversas fuentes enumeradas en la sección “Fuentes de datos

actualmente soportadas” de este documento.

La plataforma cuenta con funcionalidades de visualización, combinación de

consultas, transformación, limpieza de datos y ejecución de fórmulas y consultas

Leer más...

1. Introducción

Dagster [https://dagster.io/] es una plataforma para la orquestación de flujos

de datos. Dagster permite la creación de ‘Jobs’ (o ‘Trabajos’) que orquestan el

flujo de datos entre componentes lógicas llamadas ‘Ops’. El desarrollo de los

‘Jobs’ puede hacerse de manera local y desplegarse en cualquier sitio.

Leer más...

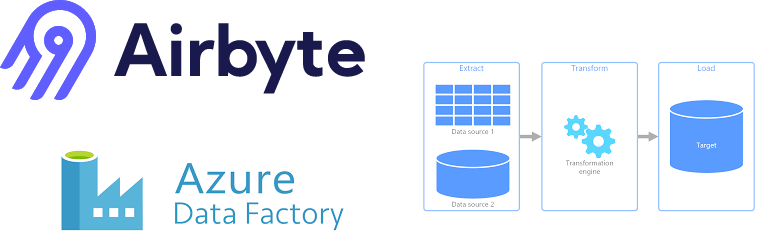

El propósito de este documento es hacer una demo y una comparativa de la

herramienta Airbyte [https://airbyte.io/] con Azure Data Factory

[https://azure.microsoft.com/es-es/services/data-factory/].

Se van a tratar los aspectos generales de la herramienta Airbyte, una plataforma

EL(T) que nos ayuda a la

Leer más...

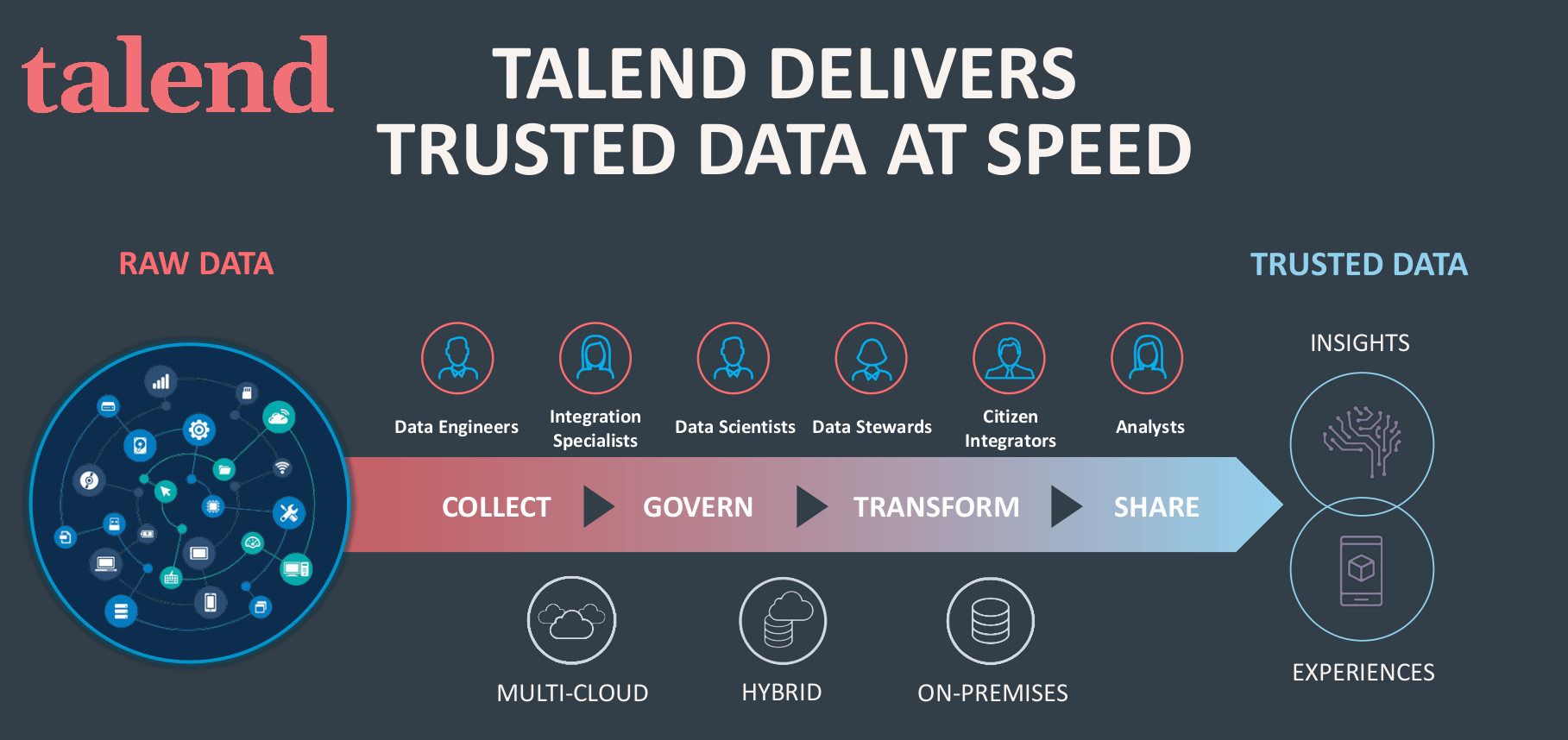

> *Actualizado. Inscríbete al webinar para conocer todo sobre Talend gratuitamente

:

> Talend, conoce la mejor solución para Gobierno del Dato e Integración

> 14 de abril 10:00h-11:30h

> Registro [https://www.stratebi.com/talend]

Tip 1: Jobs explicativos

Resumen: El propósito de este tip es recordar la

Leer más...

Apache NiFi [https://nifi.apache.org/] es un sistema de flujo de datos basado en

los conceptos de programación basada en flujo (FBP, del inglés Flow-Based

Programming).

Descargar Tutorial en español [https://stratebi.es/todobi/Feb21/Apache_NiFi.pdf]

sobre Apache Nifi

Admite gráficos dirigidos de enrutamiento de datos, transformación

Leer más...

Os presentamos una herramienta Open Source muy interesante de los

desarrolladores de Lyft (el blablacar americano): Amundsen.io

[https://www.amundsen.io/]. Os contamos lo que puede hacer

Descubrir datos de confianza

Busca datos dentro de la organización mediante una simple búsqueda de texto. Un

algoritmo de búsqueda inspirado en

Leer más...

Cada vez es más importante, para la construcción de robustos y completos Data

Lakes, así como de potentes Dashboards y sistemas de información analítica,

integrar las fuentes de datos más importantes de las organizaciones

Por ello, en este paper gratuito, os indicamos como podemos conectarnos a las

diferentes aplicaciones de

Leer más...

Apache Beam es un modelo unificado de código abierto para definir pipelines de

procesamiento de datos por lotes o de streaming. Actualmente, Apache Beam SDK

tiene soporte para tres lenguajes de programación: Java, Python y Go. Los

pipelines se programan usando uno de los SDKs mencionados anteriormente y luego

se

Leer más...

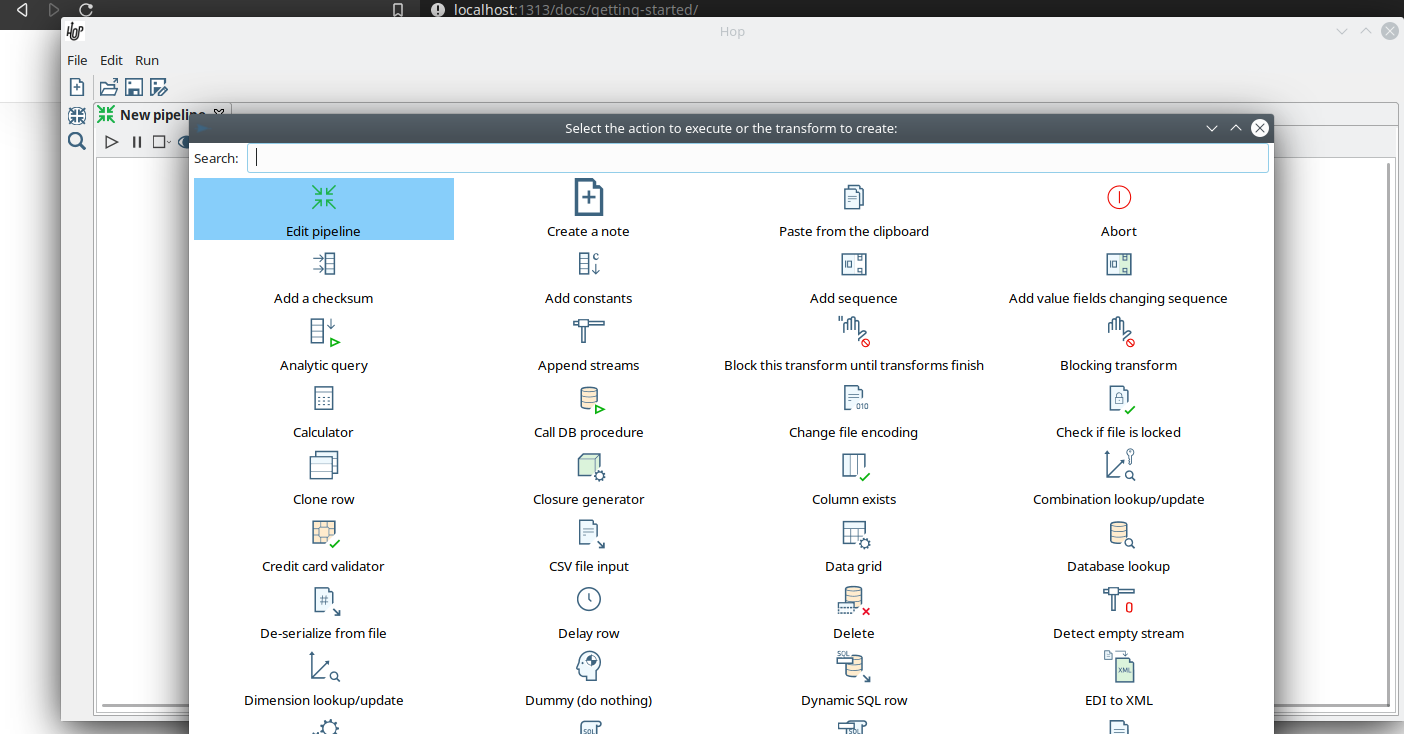

Gracias al gran Matt Casters, buen amigo, creador de Kettle (Pentaho Data

Integration), se encuentra embarcado en el desarrollo de una nueva herramienta

ETL open Source, Hop (os contamos todas las novedades que ya incluye:

Aquí puedes descargar el paper gratuito

[http://stratebi.es/todobi/Ago20/Hop_ETL.pdf] en

Leer más...